2024-08-27 09:08:59

453

432

Requests库,作为Python最知名的开源模块之一,目前支持 Python 2.6~2.7以及Python 3的所有版本,Requests由 Kenneth Reitz开发,如图1-3所示,其设计和源码也符合Python风格(这里称为Pythonic)。作为HTTP库,Requests的使命就是完成HTTP请求。对于各种HTTP请求,Requests都能简单漂亮地完成,当然,其中 GET方法是最为常用的:如果想要为URL的查询字符串传递参数(如当你看到了一个URL 中出现了“?_python 爬虫 html script

2024-08-22 23:08:51

889

136

本文介绍了JsonPath的基本概念、语法、表达式示例和过滤器,以及如何在Python爬虫中使用JsonPath提取汽车之家汽车品牌的案例。JsonPath作为处理JSON数据的强大工具,提高了爬虫的效率和准确性。

2024-08-21 10:08:21

455

707

在此项目研究中,信息收集作为探讨京城大气状况影响要素的初始环节,肩负着为后续剖析和范式构建提供基础资料的关键职责。为了全方位精确地获得相关信息,本课题运用了基于Python语言编制的自动化网络爬虫软件,高效地从公开气象站点上抓取首都各地区的空气品质和气候数据,总计3万余条有效记录。这一信息采集流程不仅涉及数据的获取,还包含了信息的预处理与贮存,保证了资料的精确性和适用性。首先,课题确立了信息采集的对象与范畴,界定了须要收集的空气品质指标,涵盖但不局限于气温、风速、风向、AQI等气象因子。

2024-08-19 22:08:40

380

214

我们详细解析了Flask框架的源码和ECharts的可视化技术。掌握了如何初始化Flask应用、配置路由与视图函数、处理请求与响应、使用中间件。同时,深入学习了ECharts的安装与配置、基本图表类型、样式与交互、数据动态更新等内容。? 最后,通过结合Flask与ECharts,我们实现了数据爬取后的可视化展示,为数据分析提供了强有力的工具。希望这些内容能够帮助大家更好地理解和应用Flask与ECharts,实现高效的数据展示!?。_如果从界面抓取数据然后制作可视化图表

2024-08-19 22:08:36

135

884

这两天我们学习的量有点大,各位uu们可以根据自己的情况来学习,主要是去多花时间练习。以良好的心态面对生活,你的生活才美好。_html xpath

2024-02-26 20:02:04

138

784

jsoup 是一款基于 Java 的HTML解析器,它提供了一套非常省力的API,不但能直接解析某个URL地址、HTML文本内容,而且还能通过类似于DOM、CSS或者jQuery的方法来操作数据,所以 jsoup 也可以被当做爬虫工具使用,从网站获取dom结构,从而解析下载数据。tagname: 通过标签查找元素,例如通过"a"来查找< a >标签。#id: 通过ID查找元素,比如通过#logo查找< p id=“logo”>_jsoup

2024-08-18 00:08:04

808

363

在JavaScript逆向工程中,字体反爬(Font Anti-Scraping)是一种常见的反爬虫技术,它通过自定义字体来显示网页中的文字,使得这些文字在标准字体库中无法直接识别,从而增加爬虫获取文本内容的难度。本文将教会你破解字体反爬的方法

2024-08-10 22:08:52

129

244

Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习 Python 门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!_python beautifulsoup查找html标签

2024-08-10 00:08:29

705

326

JSON 是很多开发者工作中经常使用的数据格式,一般多用于配置文件或网络数据传递之类的场景。并且由于其简单易懂,可读性较好等特点,JSON 也成为了整个 IT 世界几乎最常见的格式之一了。对于这样的东西,Golang 和其他很多语言一样,也提供了标准库级别的支持,也就是。就像 JSON 本身简单易懂一样,用于操作 JSON 的库也非常容易上手。但我相信许多小伙伴可能和我当初刚使用这个库时一样,都遇到过各种奇奇怪怪的问题或 bug。_golang json解析太蠢

2024-08-10 00:08:41

340

162

HTML 结构解析是 Web 爬虫中的核心技能之一,它允许你从网页中提取所需的信息。Python 提供了几种流行的库来帮助进行 HTML 解析,其中最常用的是和lxml。

2024-08-07 00:08:45

708

303

本文探讨了三种在Python中执行和处理JavaScript的方法:pyexecjs用于在内存中执行纯JavaScript,selenium则模拟浏览器环境处理DOM和WebAPI,而Node.jsAPI允许通过HTTP接口调用JavaScript。每种方法各有优缺点,适用于不同的场景需求。

2024-08-07 00:08:45

617

844

jQuery是什么jQuery是一个快速、简洁的JavaScript框架。jQuery设计的宗旨是“write Less,Do More”,即倡导写更少的代码,做更多的事情。它封装JavaScript常用的功能代码,提供一种简便的JavaScript设计模式,优化HTML文档操作、事件处理等功能。jQuery兼容各种主流浏览器,如IE 6.0 、FF 1.5 、Safari 2.0 、Opera 9.0 等jQuery的版本。_python爬虫jquery.min.js csdn

2024-07-24 23:07:50

361

14

jsonpath简单解析淘票票网站,获取城市名称_使用jsonpath爬取网站代码

2024-07-22 01:07:09

167

528

nodejs douyin网页端搜索接口及x_bogus、a_bogus(包含完整源码)(2024-06-13)_154.9234.110

2024-07-10 22:07:38

959

502

真的好久没更了……提示:以下是本篇文章正文内容,下面案例可供参考滑块获取验证码。_翼支付逆向

2024-06-26 23:06:07

728

738

JSON(JavaScript Object Notation) 是一种轻量级的数据交换格式。易于人阅读和编写。同时也易于机器解析和生成。_delphi 解析复杂json

2024-06-20 00:06:46

116

137

python爬虫六部曲: 第一步:安装requests库和BeautifulSoup库 第二步:获取爬虫所需的header和cookie 第三步:获取网页 第四步:解析网页 第五步:分析得到的信息,简化地址: 第六步:爬取内容,清洗数据_python读取html文件内容

2024-06-14 09:06:17

500

794

Json(JavaScript Object Notation)是一种轻量级的数据交换格式,具有数据格式简单,读写方便易懂等很多优点。许多主流的编程语言都在用它来进行前后端的数据传输,大大的简化了服务器和客户端的开发工作量。相对于 XML 来说,更加的轻量级,更方便解析,因此许多开发者都遵循 Json 格式来进行数据的传输和交换。_post json

2024-06-09 10:06:28

536

57

『scrapy爬虫』03. 爬取多个页面(详细注释步骤)_爬取一个网站的多个页面数据

2024-06-04 10:06:33

474

328

sector,xpath,css,re

2024-06-04 10:06:58

396

579

在请求中自定义Headers和Cookies是常见需求,# 自定义Headers和CookiesWin64;在本篇博客中,深入探讨了这一Python爬虫库,揭示了其强大而灵活的功能。通过详细的示例代码和实际应用场景,展示了如何使用该库进行HTTP请求、HTML解析、JavaScript渲染以及高级功能的应用。的异步支持使得并发请求变得轻而易举,通过连接池和缓存的利用,我们能够更好地优化性能,提高爬虫的效率。同时,库内置的强大选择器和灵活的数据提取方式让页面解析变得更为简单。总体而言,_requests-html

2024-05-29 10:05:47

661

910

CSS是Cascading Style Sheets的缩写,中文名叫层叠样式表,是一种标记语言,用于为HTML文档定义布局,涉及字体、颜色、边距、高度、宽度、高级定位等方面。_python爬虫时使用css

2024-05-24 08:05:56

714

783

JSONPath是一种用于在JSON(JavaScript Object Notation)数据中定位和提取特定元素的查询语言。它类似于XPath对XML的作用,可以帮助我们轻松地按照特定的路径表达式从复杂的JSON结构中获取所需的数据。通过使用JSONPath,开发人员可以更有效地处理和解析JSON数据,同时减少冗余代码和手动遍历的工作量。它在Web开发、API集成、数据转换等领域具有广泛的应用。_jsonpath

2024-05-22 09:05:59

66

778

本项目运用 Python爬虫技术爬取电影Top250网页数据,使用BeautifulSoup和正则表达式进行解析,存于excel和sqlite数据库中。数据可视化应用Flask 框架,使用Echarts呈现电影评分分布图,使用jieba进行文本分析,WordCloud生成电影“词云”。_电影爬取存储可视化

2024-05-19 09:05:31

850

213

不过从数据来看,爬取的数据存在重复的情况,但是此时由于请求次数过多,已经触发了B站的风控策略,暂时没法继续调试了,剩下的去重工作就交给你了,年轻人!B站目前视频搜索结果的分页策略是每页36条数据,假设我们以第4页为例,那么截至第4页,当前的视频总数就是。也就是说,这部分是固定不变的,不管你当前页码是多少页也不影响。,但是这里却包含了一些奇奇怪怪的地址,比如开头那几行就没意义,后面这些地址也不是完整的。额,有点跑题了,其实不需要知道的如此准确。下面是爬取页码数据之后的结果,符合条件的。开头得完可访问的视频。_b站爬取搜索结果

2024-05-18 18:05:35

789

261

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。最后祝大家天天进步!_python requests-html

2024-05-11 23:05:21

71

652

在当今信息爆炸的时代,网络数据的获取和处理变得至关重要。对于 Java 开发者而言,掌握高效的网页抓取技术是提升数据处理能力的关键。本文将深入探讨三款广受欢迎的 Java 网页抓取工具:Jsoup、HtmlUnit 和 WebMagic,分析它们的功能特点、优势以及适用场景,以助开发者选择最适合自己项目需求的工具。_webmagic和jsoup

2024-05-10 22:05:28

970

240

Beautiful Soup支持Python标准库中的HTML解析器(html.parser),有如下特点:1,功能:Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.2,编码问题:Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful Soup就不能自动识别编码方式了。

2024-05-06 09:05:15

253

997

JSON是⼀种存储和交换数据的语法JSON仅仅是⽂本,它能够轻松地在服务器浏览器之间传输JSON的数据格式其实就是python里面的字典格式。_python requests json

2024-05-05 12:05:50

611

601

已解决requests.exceptions.JSONDecodeError: Expecting value: line 1 column 1 (char 0)_requests.exceptions.jsondecodeerror: expecting value: line 1 column 1 (char

2024-04-23 22:04:19

1040

498

【代码】【头歌】——数据分析与实践-python-网络爬虫-Scrapy爬虫基础-网页数据解析-requests 爬虫-JSON基础。_网页数据解析头歌实践

2024-04-12 20:04:34

392

952

网页是构成网站的基本元素,它是一个包含HTML标签的纯文本文件,通常是由图片;链接;视频;声音;文字等元素组成。通常我们所看到的网页,常以 .htm 或 .html 后缀结尾的文件,因此将其俗称为HTML文件。HTML;CSS;JS是学习爬虫的基础,是必须要了解的,此篇文章我讲述了HTML5对于爬虫所要必备的基础知识_html5基本元素讨论

2024-04-09 23:04:54

606

135

大家好,我是yma16,本文分享关于前后分离django vue echarts可视化查询CSDN用户质量分。python爬虫_基本数据类型python爬虫_函数的使用python爬虫_requests的使用python爬虫_selenuim可视化质量分Django是一个开源Python web框架,由Django Software Foundation负责维护。它采用了“MTV”(模型、模板、视图)的设计架构,以使代码的复用、维护和可扩展性更加容易。_django vue echarts

2024-03-31 09:03:05

979

539

在互联网时代,数据已经成为了重要的资源。Web爬虫作为一种自动化获取数据的工具,在数据分析、市场调研、价格监控等领域发挥着越来越重要的作用。简单来说,Web爬虫是一种程序,它模拟人类在浏览器中的行为,自动访问网站并抓取所需的数据。通过爬虫,我们可以快速、高效地收集大量信息,为决策提供有力支持。然而,随着网站对爬虫的限制和反爬虫技术的不断发展,传统的爬虫方法已经难以满足需求。逆向爬虫技术应运而生,它通过对目标网站的反爬虫机制进行深入分析,并采取相应的对策,从而成功获取数据。

2024-03-12 01:03:00

391

587

其中url可以直接浏览器访问地址直接解析页面,也可以通过分析页面请求接口(开启google浏览器F12开发者模式,刷新对应页面即可查看请求数据地址 -- >> 具体数据需要通过分享查看)_java爬虫 htmlunit

2024-03-10 11:03:22

624

142

JS逆向进阶篇【去哪儿旅行登录】【下篇-逆向Bella参数JS加密逻辑&Python生成】

2024-03-04 10:03:08

795

865

今天是1024,一个特殊的日子,发一个小项目吧!也意味着我要开始写项目专栏好了,陆陆续续会将之前写的项目总结到博客中,因为属实拖得有点久了,本次的项目是基于flask echarts的疫情监控系统!_基于 python flask echarts 打造的一个疫情监控系统

2024-03-02 09:03:29

470

338

如果我们要选择的 元素 没有id、class 属性,或者有些我们不想选择的元素 也有相同的 id、class属性值,怎么办呢?这个的意思是 div标签的class类中的叫footer1的子元素span标签的class类的叫copyright。post我们平时是要加data的也就是信息,你会发现我们平时百度之类的 搜索都是post请求。这个方法是用我以前用的动态网页爬取的爬的。css注意“空格”不能乱加,这个是根据白月黑雨写的这个爆赞!get我们带的是params,是发送我们指定的内容。

2024-02-27 11:02:54

877

795

管理员功能模块包括:首页、人员管理(管理员、学生用户、院级教师)、模块管理(就业信息、就业上报、校院消息)个人管理(个人信息、修改密码);用户功能模块包括:首页、模块管理(就业信息、就业上报、校院消息)、个人管理(个人信息、修改密码):院级教师:首页、模块管理(就业信息、就业上报、校院消息)、个人管理(个人信息、修改密码)。

2024-02-19 09:02:40

901

90

1.什么是jQuery爬虫jQuery爬虫是一种利用jQuery库和JavaScript技术来抓取网页数据的方法。它可以帮助我们从网页中提取所需的信息,如文本、图片、链接等,并进行进一步的处理和分析。2. jQuery爬虫的优势使用jQuery爬虫可以轻松实现网页数据的抓取和处理_get?callback=jquery 爬虫

2024-02-05 11:02:46

283

735

很多时候,我们可能喜欢某些网页的所有图片,却又觉得一张张下载过于繁琐,所以我教大家可以通过python快速得到所有图片_python在一个网站中获取照片并且保存

2024-02-02 09:02:58

518

784

系统采取MySQL作为后台数据的主要存储单元,采用Thinkphp框架、PHP技术、Redis技术进行业务系统的编码及其开发。本系统有管理员、用户,管理员:管理员:首页、个人资料(个人信息、修改密码)、公共管理(轮播图、公告信息)、用户管理(管理员、系统用户)、信息管理(交流论坛、论坛分类、新闻资讯、资讯分类)、文物信息、类型管理、展会信息、购票记录,用户;首页、交流论坛、公告信息、新闻资讯、文物信息、展会信息、购票记录、我的(我的账户、我的收藏、个人中心)跳转到后台等操作。

2024-01-26 10:01:39

674

540

本文主要学习一下关于爬虫的相关前置知识和一些理论性的知识,通过本文我们能够知道什么是爬虫,都有那些分类,爬虫能干什么等,同时还会站在爬虫的角度复习一下http协议。本阶段本文主要学习响应之后如何从响应中提取我们想要的数据,在本阶段本文中我们会讲解一些常用的方法和模块,基本上我们以后遇到的情况在掌握本阶段本文之后都能搞定_lxml 获取html

2024-01-25 11:01:07

708

823

爬虫是一种自动化工具,用于从互联网上获取数据。代理IP是一种用于隐藏真实IP地址并改变网络请求的方法。在爬虫中使用代理IP可以帮助我们采集大量数据时绕过反爬虫机制,并提高爬取效率。本文将介绍如何使用代理IP通过HTML和CSS采集数据,并提供相关代码示例。在本文中,我们介绍了如何使用代理IP通过HTML和CSS采集数据,并提供了相关代码示例。使用代理IP可以帮助我们在爬虫过程中绕过反爬虫机制,并提高爬取效率。在使用代理IP进行数据采集时,我们需要获取和验证代理IP列表,并配置代理参数。

2024-01-24 15:01:05

614

620

某查查请求头加密参数JS逆向分析,使用Python爬取更多企业工商信息_a.default.encryptedstring

2023-05-14 16:05:12

633

28

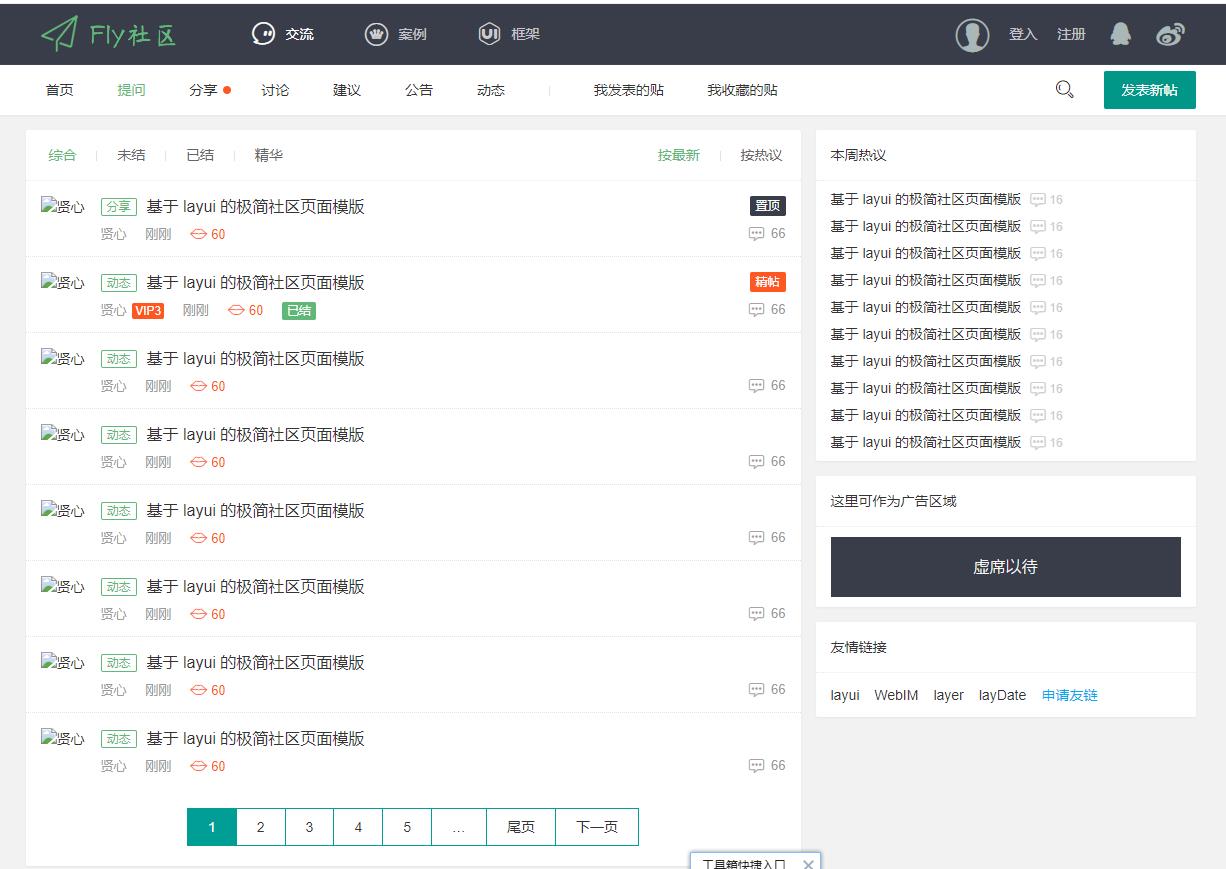

基于 layui 的极简社区页面模版:Fly Template v3.0 所有页面目录页面目录首页index.html帖子相关列表jie/index.html详情jie/detail.html发帖/编

热门排行